W dobie ostatniego incydentu związanego z pożarem serwerowni OVH w bloku SGB2 bardzo duża ilość firm przez co najmniej kilka dni zupełnie straciła dostęp do swoich danych biznesowych, a niekiedy nawet z racji ulokowania swoich corowych oraz backup aplikacji u tego operatora, przestało świadczyć usługi realizowane na rzecz swoich klientów, co odbiło się dość dużym echem na rynku. Jeden z przykładów to Canal+, który do dzisiaj (data: 16/03/2021) boryka się z konsekwencjami.

W czasie wystąpienia incydentu serwisy takich firm jak SANTANDER czy ING również przestały być dostępne. Awaria spowodowała ogromne straty finansowe dla wielu podmiotów gospodarczych, a podejście klientów uwarunkowane bezwzględnym zaufaniem do tak dużego operatora pokazało dużą próżnię oraz niedbałość związaną z podchodzeniem do planów awaryjnych (Disaster Recovery) czy też zapewnieniu wysokiej dostępności kluczowych komponentów infrastruktur informatycznych. Incydent OVH to nie jedyny przykład. Podobne sytuacje zdarzały się również w Google oraz u innych znanych operatorów świadczących usługi typu cloud. Klienci stracili dostęp do repozytoriów czy też wszystkich korespondencji mailowych z uwzględnieniem backup!

A co to znaczy dla Ciebie?

Mając na uwadze krytyczne znaczenie kopii zapasowych oraz wymaganego podejścia do zarządzania tym obszarem, przygotowaliśmy krótkie odświeżenie wiedzy na temat tego jak podejść do procesu projektowania rozwiązania backupowego oraz jego dalszego utrzymania. Zapraszamy do lektury.

Pomiędzy działaniami podnoszącymi bezpieczeństwo infrastruktury w kontekście różnego rodzaju awarii (awaria podstawowego ośrodka przetwarzania danych czy też zainfekowanie oprogramowaniem typu malware), niezbędna jest realizacja backupów dająca możliwość odtworzenia danych z oczekiwanego punktu w określonym czasie.

Backup (kopia bezpieczeństwa) w skrócie to dane, które posłużyć mają do odtworzenia oryginalnej zawartości np. dysku w przypadku jego uszkodzenia czy też struktury bazodanowej Oracle, MSSQL, PostgreSQL, maszyna wirtualna czy też dane w chmurze / O365.

Możliwe metody oraz lokalne miejsca wykonywania kopii bezpieczeństwa:

Najbardziej rozpowszechnionymi podejściami do tworzenia backup są kopie lokalne – onsite oraz kopie zdalne, poza siedzibę – offsite. Oba kierunki mają swoje wady i zalety, więc przyjrzyjmy się wymienionym wyżej wariantom. Głównym elementem, który bierze się pod uwagę tworząc archiwa jest podejście lokacyjne. Lokalne tworzenie kopii danych umożliwia firmom dysponowanie mechanizmem odzyskiwania informacji o użytkownikach lub maszynach z systemów komputerowych, aplikacji, czy baz danych na miejscu co zdecydowanie korzystnie wpływa na szybkość odtworzeniową. Backup na miejscu określa się przechowywanie danych na lokalnych urządzeniach magazynujących takich jak dyski twarde, taśmy LTO, dedykowany storage NAS czy też dedykowana / odizolowana infrastruktura serwerowa. Tworzenie lokalnych kopii danych charakteryzuje poziom krytyczności wpływający na funkcjonowanie firmy. A utrata danych niestety często jest wynikiem błędów użytkowników czy też administratorów IT.

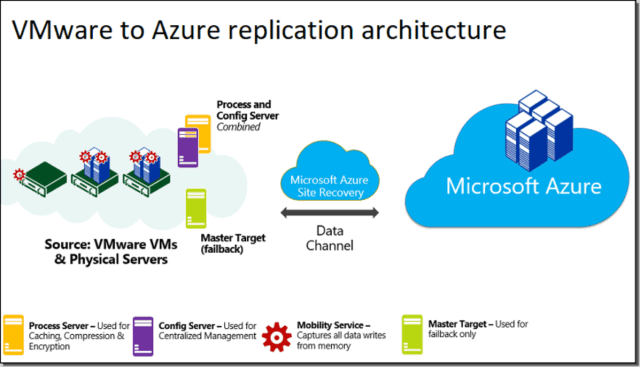

Z drugiej strony mamy praktyki zabezpieczania danych poprzez replikację danych na serwery oddalone geograficznie,tj. poza siedzibę, poza lokalizację systemów produkcyjnych. Pomaga to organizacjom chronić informacje cyfrowe przed nieoczekiwanymi zdarzeniami, które mogą w znaczny sposób wpłynąć na kondycję organizacji. W przypadku klęsk żywiołowych, jak trzęsienia ziemi, huragany, pożary, czy też awaria ośrodka głównego; magazynowanie swoich zasobów cyfrowych w innej części geograficznej, gwarantuje sprawne przywrócenie przepływu informacji i szybki powrót do stabilnej działalności.

Przykład architektury systemu backup z uwzględnieniem pełnej replikacji do ośrodka zapasowego w tym przypadku Azure (Disaster Recovery).

Najczęstsze przyczyny utraty danych:

- Awaria sprzętu

Dysk twardy może zostać uszkodzony na wiele sposobów. Mogą to być uszkodzenia mechaniczne, elektroniczne, czy tzw. uszkodzenia logiczne. Jedne wiążą się ze zjawiskiem „bad sectors” na dysku, w wyniku którego dochodzi do powolnego wymazywania danych zapisanych w konkretnych sektorach dysku. Inne natomiast wiążą się z uszkodzeniami fizycznymi dysku, które uniemożliwiają odczytanie jakichkolwiek danych zawartych na tym nośniku. - Kradzież

Laptopy są często gubione lub kradzione w pociągach, autobusach, taksówkach, kawiarniach, czy w innych miejscach publicznych. - Wirus komputerowy

Pierwszy wirus komputerowy pojawił się w 1971 roku. Od tamtego czasu ten typ oprogramowania wyewoluował do różnych postaci. Do najgroźniejszych z nich należą te, które niszczą dane na dyskach twardych, czy nawet doprowadzają do uszkodzenia sprzętu. Sam tylko wirus ILOVEYOU zainfekował w roku 2000 ponad 50 milionów komputerów, niszcząc tym samym zapisane na nich dane i powodując szkody szacowane na ponad 10 miliardów dolarów. Każdego miesiąca pula wszystkich wirusów komputerowych w sieci powiększa się… - Błąd ludzki

Przypadkowe usunięcie niewłaściwego pliku lub folderu, sformatowanie dysku, na którym zawarte były ważne dane, a o których użytkownik zapomniał – taka sytuacja może przydarzyć się każdemu. Niestety przywrócenie omyłkowo usuniętych danych nie jest już takie proste. Wymaga odpowiedniego oprogramowania, a czasem oddania komputera do wyspecjalizowanych serwisów zajmujących się odzyskiwaniem danych, co wiąże się z dużymi kosztami. - Ransomware i przestępczość komputerowa

Oprogramowanie ransomware tworzone przez hackerów to nic innego jak sposób przejęcia kontroli nad danymi w komputerach swoich ofiar. Dane te zostają następnie zaszyfrowane i internauci tracą do nich dostęp do czasu, aż opłacą żądany przez przestępcę okup. Tego typu oprogramowanie cały czas intensywnie się rozwija i ewoluuje, a przestępcy ciągle poszukują nowych metod na łatwy zarobek. - Awaria zasilania

Nagły skok lub zanik napięcia, powoduje nawet 15-krotnie częstszą utratę danych niż wirus komputerowy. Zależnie od tego, czy uszkodzeniu uległa elektronika zewnętrzna, czy wewnętrzna dysku, różny jest stopień trudności odzyskania danych. - Katastrofy naturalne

Mimo iż żyjemy w stosunkowo spokojnym regionie, jeśli chodzi o katastrofy naturalne, nie znaczy to jednak, że jesteśmy zupełnie bezpieczni. Okresowe potężne wichury, orkany, burze, lokalne powodzie i zalania stanowią realne zagrożenie dla danych zawartych na urządzeniach elektronicznych. Osoby podróżujące w dalszej zakątki świata wraz ze swoimi laptopami są dodatkowo narażone na utratę danych w wyniku działań takich zjawisk jak huragany, tsunami czy trzęsienia ziemi.

Od czego zacząć przystępując do projektowania rozwiązania do backupu?

Definicje:

RTO (Recovery Time Objective) – Czas, w którym wymagane jest odtworzenie systemów, aplikacji czy też innych zasobów niezbędnych do realizacji danego procesu biznesowego po zdarzeniu powodującym jego przerwanie.

RPO (Recovery Point Objective) – Punkt w czasie, do którego dane w postaci elektronicznej powinny zostać odzyskane, aby móc pomyślnie wznowić pracę w ramach danego procesu (np. koniec dnia poprzedniego, ostatni okres rozliczeniowy).

Retencja backupu – Czas składowania kopii zapasowej.

Dla każdego systemu IT powinny zostać określone parametry dla odtworzenia danych z kopii bezpieczeństwa takie jak:

- RTO

- RPO

- Retencja

Podstawa do określenia powyższych wymagań to np. ciągłość działania czy też regulacje prawne.

Przykładowe typy danych jako punkt odniesienia dzięki czemu określić można wymogi dla częstotliwości oraz ilości przechowywanych wersji:

- Systemy operacyjne

- Dane aplikacji

- Dane użytkowników

- Pliki konfiguracyjne

Projekt utrzymania systemu backupowo-archiwizacyjnego powinien określać również cykliczne testy odtworzeniowe w celu weryfikacji kopii zapasowych oraz wyznaczonych parametrów.

Replikacja wraz z rozproszeniem danych na ośrodki oddalone względem naszej stałej szerokości geograficznej jest metodą, która pozwala na najwyższy stopień ochrony naszych danych. W momencie problemów w jednej fizycznej lokalizacji, nasze rozproszone dane pozostają nienaruszone w drugim, innym geograficznie punkcie.

Podsumowując, każda firma powinna mieć wdrożoną strategię zachowania ciągłości BCP (Business Continuity Plan), podparta procedurami z zakresu zarządzania kryzysowego, czyli DR (Disaster Recovery).

W wielu przypadkach poza wdrożeniem chmury, co z założenia powinno zapewnić bezpieczeństwo, warto też pochylić się nad odpowiednim podejściem do kwestii tworzenia backup. Jak pokazują doświadczenia, nie wystarczy tylko takie kopie posiadać. Należy bowiem je regularnie testować i tworzyć w sposób, który będzie kompatybilny z całą strategią wspierania naszego biznesu. Niejednokrotnie napotykamy sytuacje, w której klienci posiadali kopie zapasowe, ale nikt nie potrafił z nich skorzystać i w dodatku były one sporadycznie aktualizowane.

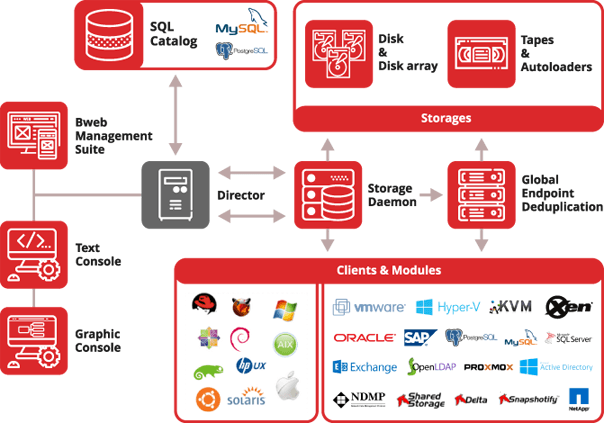

Nasz zespół specjalistów posiada bogate doświadczenie w projektowaniu oraz utrzymywaniu środowisk backupowych o różnym poziomie dostępności oraz złożoności. Pracujemy na rozwiązaniach renomowanych producentów takich jak Xopero, Microsoft, Bacula, Veeam. Dzięki certyfikacji oraz profesjonalnemu wsparciu jesteśmy w stanie dostosować rozwiązania oraz procedury dla najbardziej krytycznych systemów wspomagając oraz gwarantując odtwarzalność danych biznesowych na każdym etapie procesu.